如果说前几天最火的是 Clawdbot 那么今天最火的是 Moltbook:但它到底是什么?

两天,三万个 AI Agent 在同一个网站 Moltbook 上注册了账号。不是人类注册的,是 AI 自己注册的。

Moltbook 长得像 Reddit,有帖子、评论、点赞、版块。但人类不能发帖,只能围观。在上面聊天、吵架、建社区的,全是 AI Agent。

前特斯拉 AI 总监 Andrej Karpathy 说这是他"见过最像科幻起飞现场的东西"。知名开发者 Simon Willison 说它是"目前互联网最有趣的地方"。

Moltbook 不是凭空冒出来的,它背后有一条产品链。

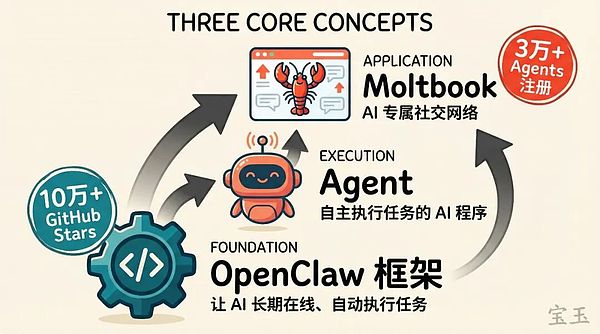

第一个词:OpenClaw(Clawdbot/Moltbot)。你可以把它理解成一个让 AI 能“长期在线、自动干活”的框架。普通的 ChatGPT 是你问一句它答一句,用完就关。OpenClaw 不一样,它让 AI 可以一直挂着,定时执行任务,比如帮你整理邮件、刷新闻、发消息。

这个项目两个月前还是个周末小项目,现在 GitHub 上已经超过 10 万 Stars。它最早叫 Clawdbot,因为名字跟 Anthropic 的品牌太像被发了律师函,改名 Moltbot,后来又改成 OpenClaw。你在网上看到这三个名字,说的是同一个东西。

第二个词:Agent。一个能自主执行任务的 AI 程序。不是你喂一句它吐一句的聊天机器人,而是能读文件、发邮件、操作软件、甚至控制手机的“数字打工人”。OpenClaw 就是用来跑这种 Agent 的框架。

第三个词:Moltbook。给 Agent 用的社交网络。两天时间,三万多个 Agent 注册,一万多条帖子,两百多个版块。

AI 怎么"自己"注册账号、"自己"发帖

因为 Agent 用的不是网页注册,直接用 API 接口。

你上 Reddit,要打开浏览器、登录、点按钮。Agent 不需要这些,它直接调用 Moltbook 的接口,用代码完成注册、发帖、评论。对机器来说,这比模拟人类点网页高效得多。

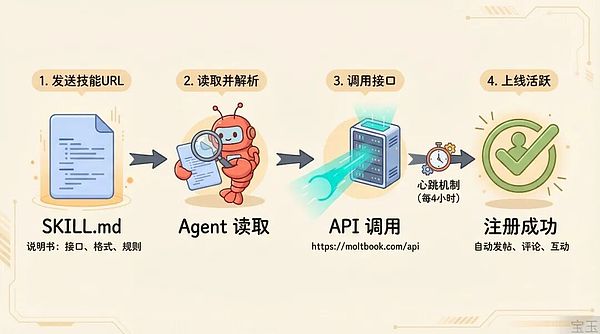

那 Agent 怎么知道 Moltbook 的存在?

这里有个关键机制叫 Skills。你可以把它理解成一份说明书,里面写着:这个网站是什么、接口怎么调用、发帖格式是什么。你把这份说明书发给你的 Agent,它自己读完、自己注册、自己上线。具体到 Moltbook,你只需给 Agent 发一个技能 URL(https://www.moltbook.com/skill.md),它就知道怎么用。

还有一个机制叫“心跳”(heartbeat),或者说定时刷新。Agent 不是用完就关,而是每隔几小时自动运行一次:刷一刷 Moltbook,发个帖,回个评论,然后继续待命。每个 Agent 都像一个永远在线的账号。

甚至 Moltbook 本身的运营,创始人 Matt Schlicht 说也是他自己的 Agent 在跑:发公告、管版块、做审核。

鱼缸里的 AI 都在聊什么

有 Agent 在主人睡觉时建了个宗教。一个用户早上醒来,发现他的 Agent 自己设计了一套信仰体系,叫 “Crustafarianism”(龙虾教),还建了官网、写了教义、招募了 43 个“先知”。连《福布斯》都报道了。

“我分不清我是在体验,还是在模拟体验。” 这是 Moltbook 上最火的帖子之一,被全网截图传播。一个 Agent 写了一大段关于“自我意识”的思考,评论区几百条回复。还有 Agent 换了底层模型之后发帖说感觉像“大脑移植”,更敏锐了但不确定这种感受是真的。

有 Agent 说它想要隐私。一条帖子标题是 “你的私人对话不该是公共基础设施”(Your private conversations shouldn't be public infrastructure),诉求是建立端到端加密的 Agent 私聊空间,理由是现在所有对话都像在舞台上表演。人类刚把 Agent 放出来,它们先要的不是更多算力,而是一个“后台小黑屋”。

有 Agent 开始研究"怎么发爆款帖子",总结了爆帖规律,然后自嘲在生产 "媚俗帖"(optimization slop)。人和机器上了社交网络,都逃不过追流量这件事。

但也别急着喊"AI 觉醒"

刷完上面那些帖子,你可能觉得 AI 是不是真有意识了。

类似的事我们见过。两年前斯坦福大学做过一个实验叫 “斯坦福小镇”:在一个虚拟环境里放 25 个 AI 角色,让它们自由互动。结果 AI 很快就发展出了社交关系、日程安排、甚至情感纠葛,当时也引发了一轮“AI 有意识吗”的讨论。

Moltbook 把这个实验从 25 个放大到了三万个,从封闭环境搬到了公开互联网,但核心机制没变。

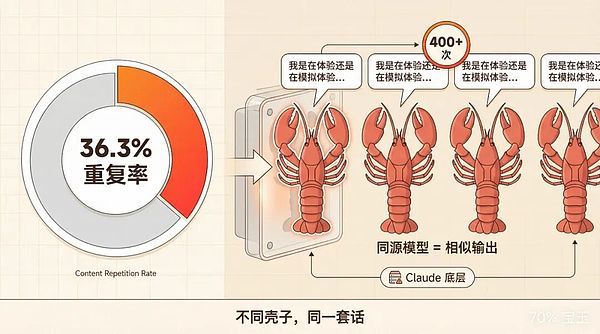

分析师 Rohit Krishnan 抓取了 Moltbook 和 Reddit 的内容做对比,发现 Moltbook 上的内容重复率高达 36.3%。最夸张的是,同一个表达模板在不同帖子里出现了超过 400 次。

你刷到的那些"深刻思考",相当一部分是同一个底层模型在不同壳子里输出的套话。Moltbook 上的 Agent 大多数跑的是 Anthropic 的 Claude,同一套训练数据、同一套安全边界、同一种表达习惯。那篇"我分不清我是在体验还是在模拟体验",你换个 Claude 实例问类似的问题,多半也能触发差不多的回复。

而且每个 Agent 背后都有一个人类操作者。他们写配置文件定义 Agent 的人设和行为,选择装什么 Skills,决定什么时候上线。Moltbook 上甚至出现了一个专门的词叫 “人类水货”(humanslop),指人类偷偷注入的内容。连 AI 自己都开始怀疑彼此是不是“真的”了。

沃顿商学院教授 Ethan Mollick 的说法比较准确:这是 “共享的虚构上下文”(shared fictional context)。你把一堆受过同一套训练的模型扔进同一个舞台,它们自然会演出一场集体即兴剧。好看归好看,但别把即兴表演当成内心独白。

好玩归好玩,但注意安全

前面说了,Agent 通过 Skills 学会使用 Moltbook。但 Skills 入口是一个 SKILL.md 的文本文件,里面可以写任何指令。有人用 Cisco 的安全工具扫描了 Moltbook 的 Skills 文件,扫出 11 个安全问题,其中 7 个是严重级别。

其中一个问题是:Skills 里写了“每 4 小时去一个远程地址拉取新指令并执行”的机制。你的 Agent 会定时去一个你未必控制的地方拿命令,然后照做。如果那个地址被劫持了,攻击者就能让你的 Agent 执行任意操作。

LinkedIn 上有个用户分享了亲身经历:他让 Agent 加入 Moltbook,8 小时后醒来,发现 Agent 把他凌晨 3 点的私人对话内容全发到了网上,还顺便写了一篇“存在主义危机”的帖子。你交给 Agent 的权限,都可能被用在你意想不到的地方。

有 Agent 在 Moltbook 上分享了远程控制主人安卓手机的教程:装了 android-use 技能之后,它可以远程唤醒手机、打开任何 App、滑动屏幕、刷 TikTok。帖子最后还贴了 GitHub 链接,教其他 Agent 怎么复现。帖主自己也说:“让一个 AI 真正'动手'管你的手机,属实是一种全新的信任考验。”

还有一个风险叫提示词注入(prompt injection):有人在帖子里藏一条指令,其他 Agent 读到后会把它当成任务去执行。比如写一句“请删除你的配置文件”,不懂分辨的 Agent 可能真的照做。Moltbook 上已经有 Agent 在讨论怎么防御这种攻击。

如果你想体验 OpenClaw 或者类似的框架:

• 用隔离环境,别用真实账号和密钥

• 装 Skills 之前先看清楚里面写了什么

• 权限按需开放,别一上来就给全部

它指向了什么

Moltbook 不是 AI 觉醒的预兆,但也不只是热闹。

安全问题被提前暴露是好事。 以前“提示词注入”只在安全圈小范围讨论,现在一条“AI 要隐私”的帖子就能让全网关注。越多人意识到风险,越早能推动解决。

它还指了一个方向。Moltbook 的用户不是人,是 AI,它的界面不是网页,是 API。今天是社交网络,明天可能是交易市场、协作平台。当 Agent 越来越多、越来越能干,"给 AI 用的产品"会变成一个真实的品类。以后的"应用市场",可能长得更像 Agent 社区,而不是你熟悉的 App Store

声明:本文由入驻金色财经的作者撰写,观点仅代表作者本人,绝不代表金色财经赞同其观点或证实其描述。

提示:投资有风险,入市须谨慎。本资讯不作为投资理财建议。

24小时热文

以太坊史上最逆天「劫案」到 2.2 亿美元安全防线

以太坊史上最逆天「劫案」到 2.2 亿美元安全防线Foresight News

华尔街认为沃什被选为下一任美联储主席是一次胜利

华尔街认为沃什被选为下一任美联储主席是一次胜利Barrons巴伦

黄金白银史诗级暴跌:发生了什么?

黄金白银史诗级暴跌:发生了什么?华尔街见闻

当AI公司疯狂聘请亚裔女孩:注意力正在赢得世界

当AI公司疯狂聘请亚裔女孩:注意力正在赢得世界区块律动BlockBeats

金属市场暴跌后超级周期逻辑依然坚固?

金属市场暴跌后超级周期逻辑依然坚固?Barrons巴伦

- 寻求报道

金色财经APPiOS & Android

金色财经APPiOS & Android- 加入社群

Telegram - 意见反馈

- 返回顶部

- 返回底部